Здравствуйте дорогие друзья! Сегодня у нас важный урок по созданию файла robots.txt. Без этого файла обойтись ни как нельзя, он помогает управлять индексированием сайта.

В этом файле прописываются команды для всех поисковых роботов. Если robots.txt прописан правильно, то ваши статьи будут быстро индексироваться и попадать в ТОПы выдачи.

Так же в этом файле указана ссылка на карту сайта Sitemap, и отсюда роботы переходят на ваш сайт. Поэтому читаем внимательно и просто повторяем настройки.

Раньше этот файл нужно было создавать отдельно, потом помещать в корневую папку, сейчас же все гораздо проще и создавать robots.txt мы будем прямо на хостинге.

И так, открываем письмо от хостинга Timeweb. Вводим логин и пароль и попадаем в «главный штаб» нашего сайта.

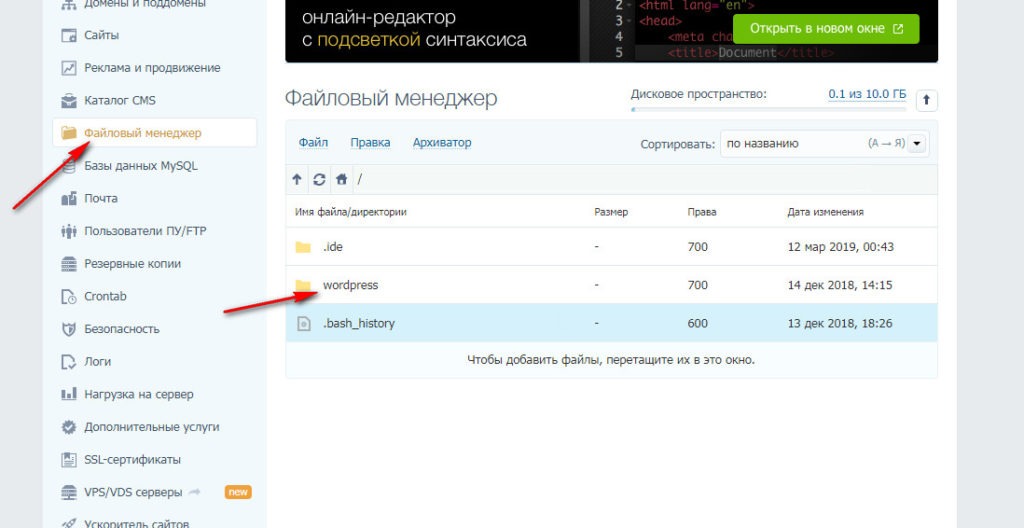

Здесь, в меню с левой стороны, жмем на «файловый менеджер» и двумя нажатиями левой клавиши мыши открываем папку wordpress.

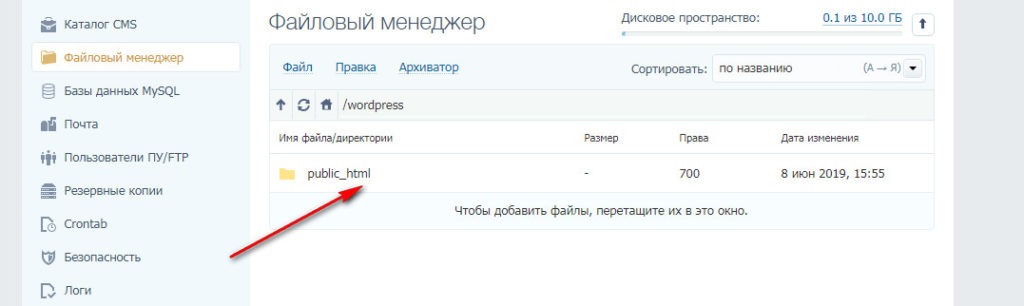

Затем нам нужно также открыть наш главный файл public_html.

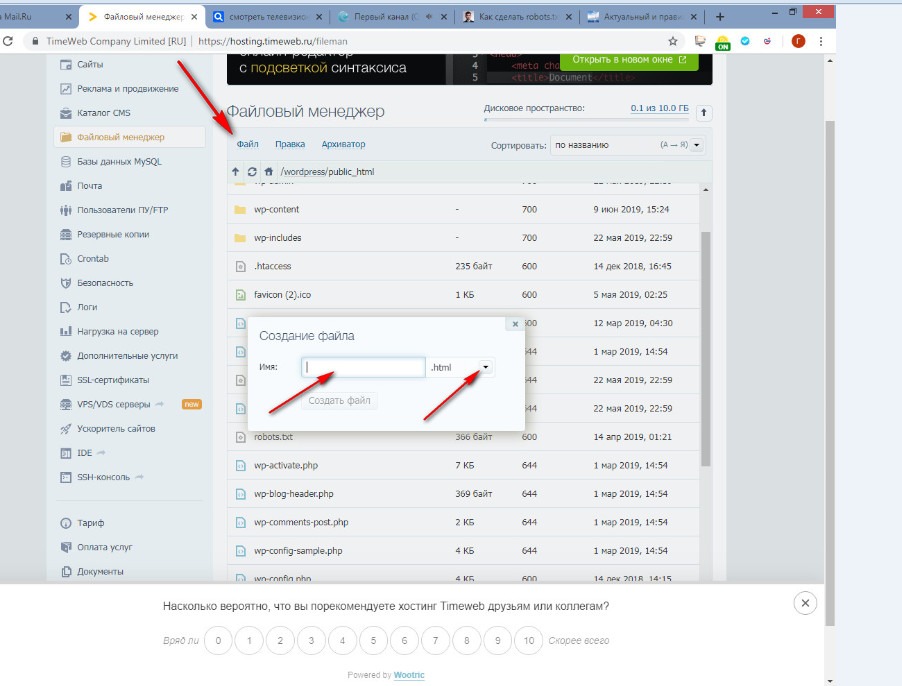

Теперь нам необходимо создать новый файл. Для этого жмем на » файл», затем «новый файл» и в открывшемся окошке вбиваем «robots.txt», затем меняем «html» на «txt», это делается при нажатии на маленький треугольник. И нажимаем » создать».

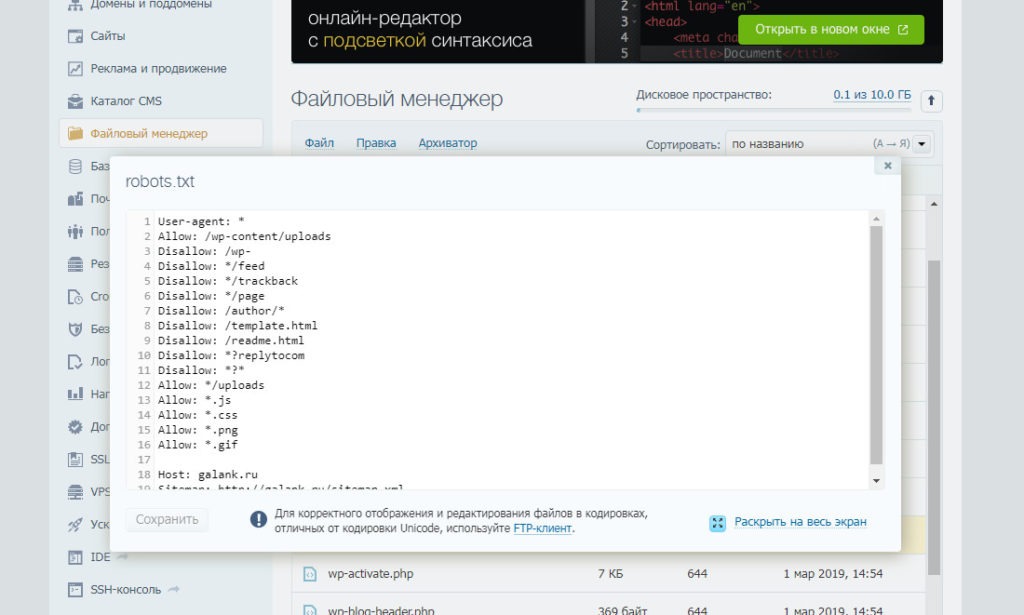

Теперь открываем любой текстовый редактор или блокнот на вашем компьютере копируем вот такую запись:

User-agent: *

Allow: /wp-content/uploads

Disallow: /wp-

Disallow: */feed

Disallow: */trackback

Disallow: */page

Disallow: /author/*

Disallow: /template.html

Disallow: /readme.html

Disallow: *?replytocom

Disallow: *?*

Allow: */uploads

Allow: *.js

Allow: *.css

Allow: *.png

Allow: *.gif

Host: ваш домен без http.ru

Sitemap: http://ваш домен.ru/sitemap.xml

Прописываем ваш домен, копируем и возвращаемся на хостинг, открываем созданный файл «robots.txt» и вставляем нашу запись и сохраняем изменения.

Поздравляю с успешной установкой важного файла! Теперь можно смело начинать писать статьи на своем сайте!

После создания robots.txt. нам нужно зайти в админку нашего сайта.

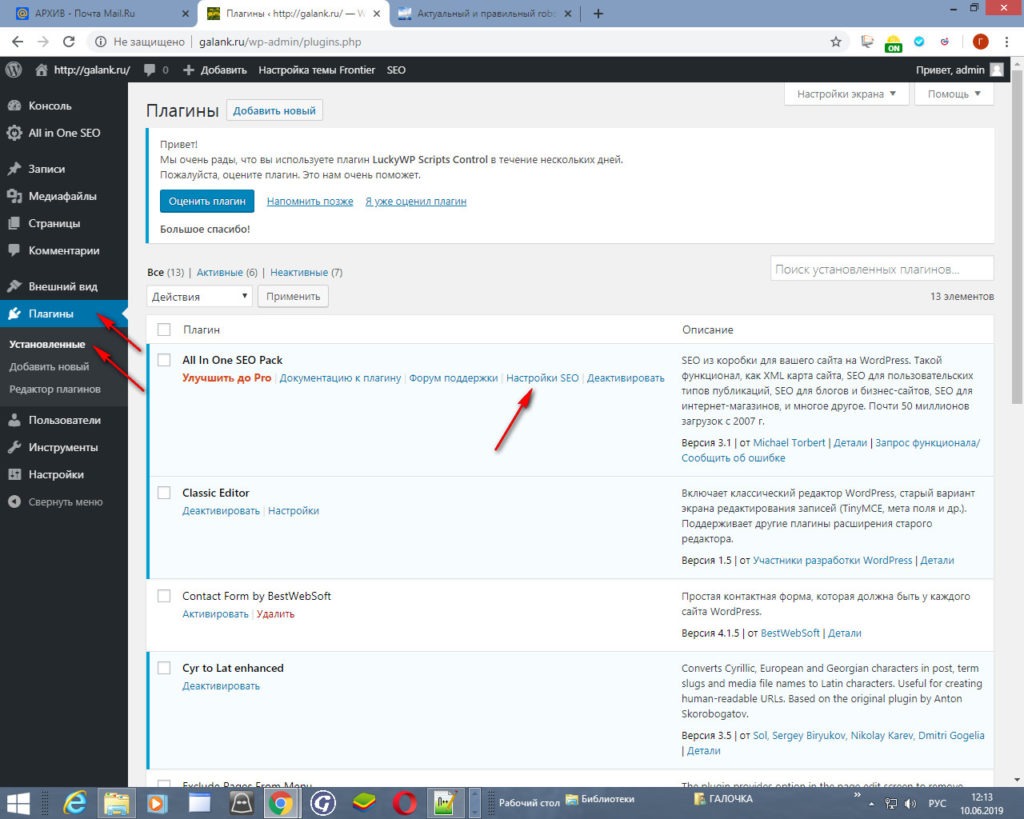

И, помните, в предыдущей статье, мы устанавливали плагины. Сегодня нам нужно настроить один из них, это SEO плагин All In One SEO Pack.

В левой стороне панели находим и жмем на «Плагины» «установленные» и в плагине All In One SEO Pack жмем на » настройки SEO»

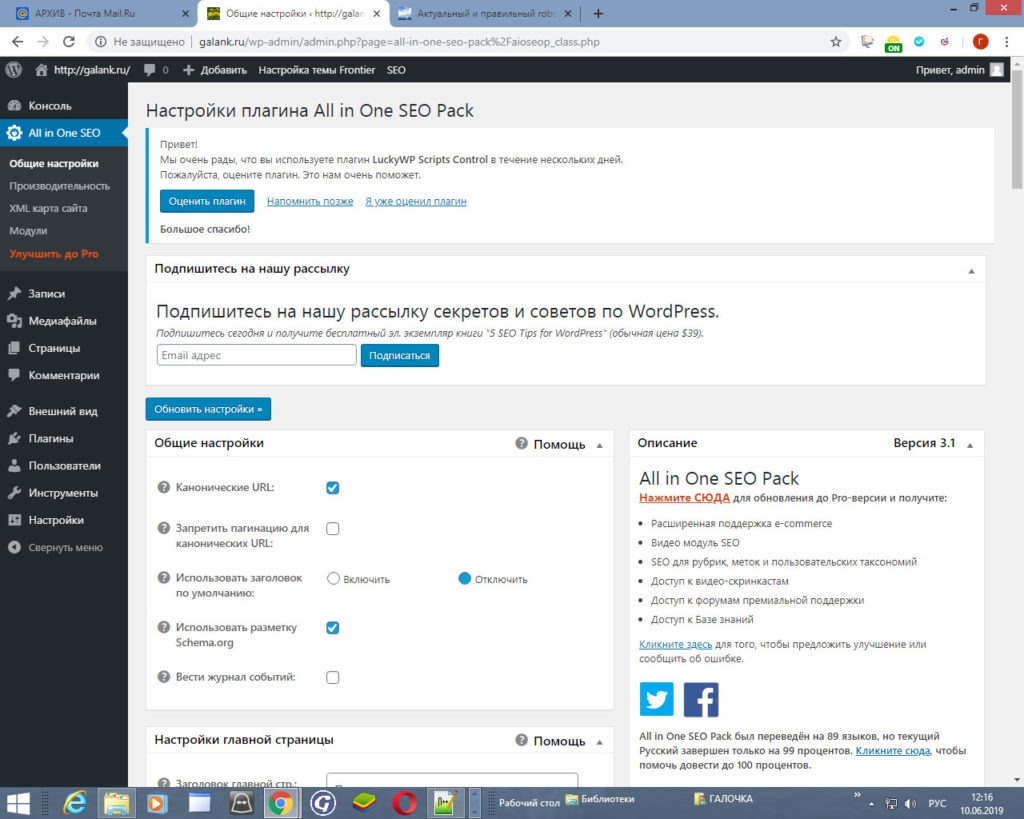

В общих настройках ставим птички » канонические URL» и еще » использовать разметку Schema.org», а так же отключаем «использование заголовка по умолчанию».

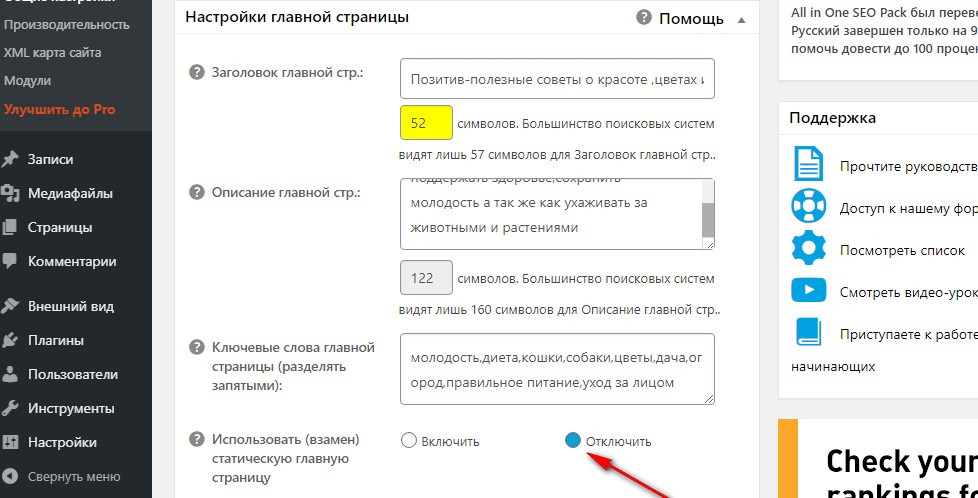

Затем опускаемся ниже и в настройках Главной страницы отключаем «Использовать (взамен) статическую главную страницу».

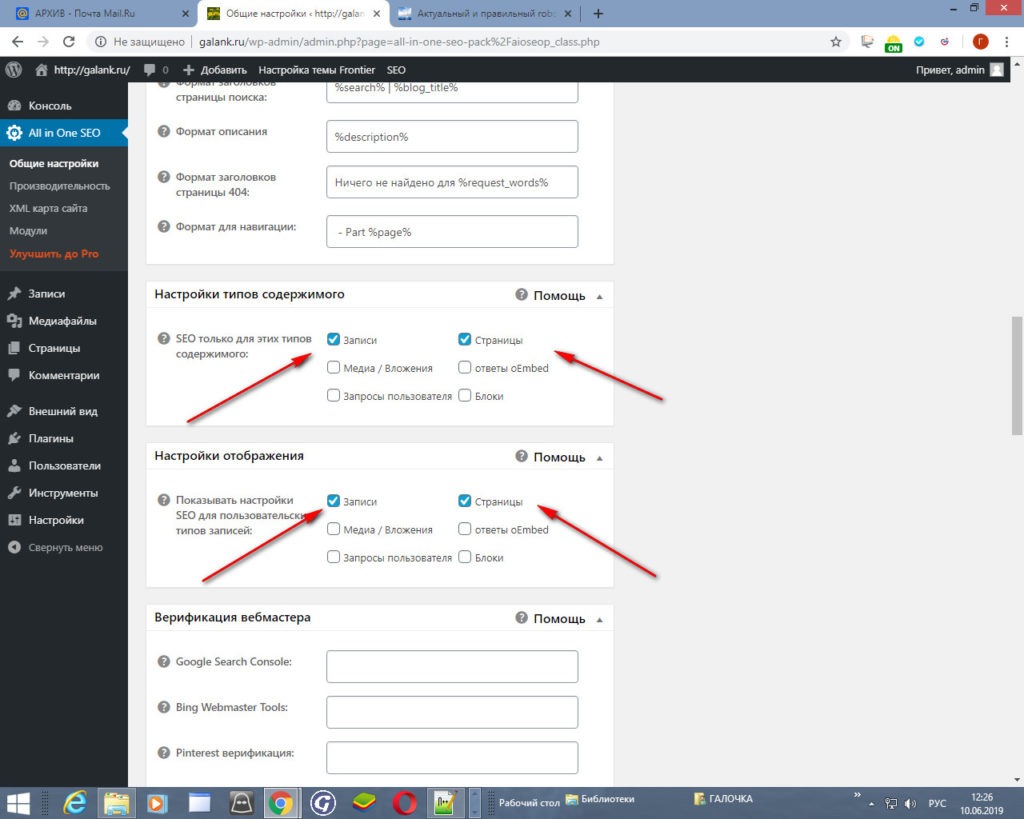

Настройки заголовков мы пропускаем. Идем к настройке » Типов содержимого» и «Настройки отображения», в этих пунктах отмечаем птичками только «записи» и «страницы».

«Верификацию вебмастера» и «Настройки Google» мы пропускаем, это мы будем делать позже и на хостинге. Здесь оставляем поля пустыми.

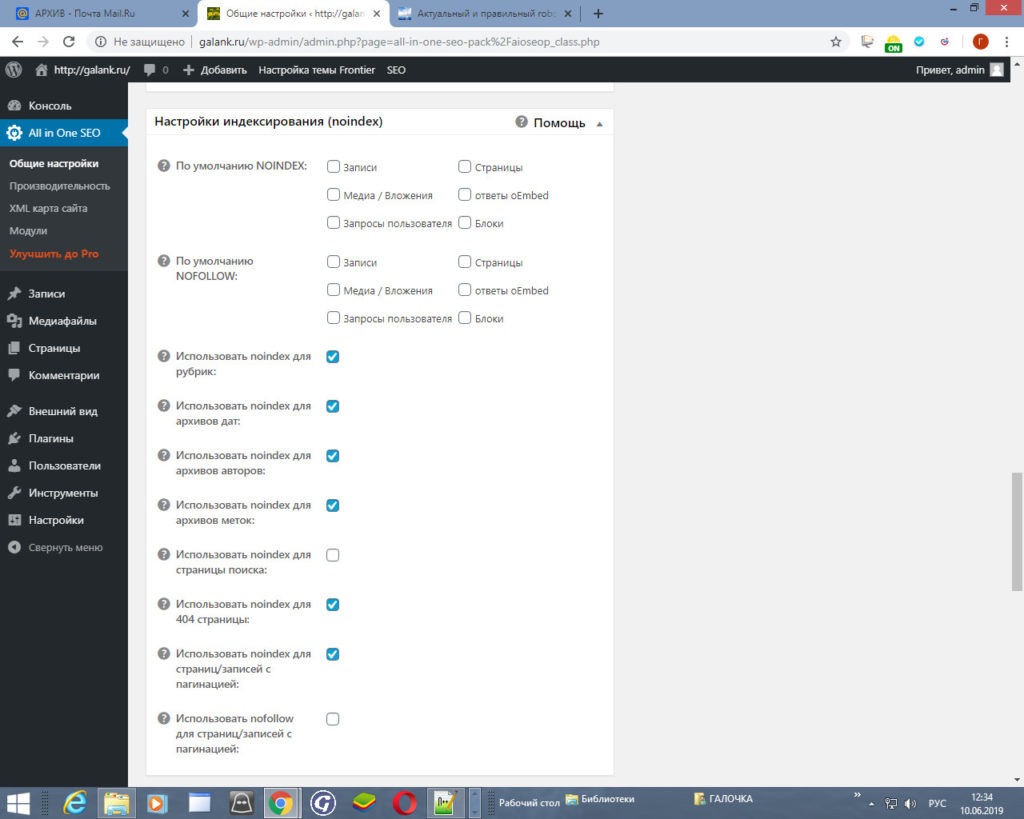

Теперь самые важные настройки в этом плагине, это » Настройки индексирования (noindex)». Здесь проставьте птички, как показано на скриншоте. Это нужно для того, чтобы не индексировались дубли страниц.

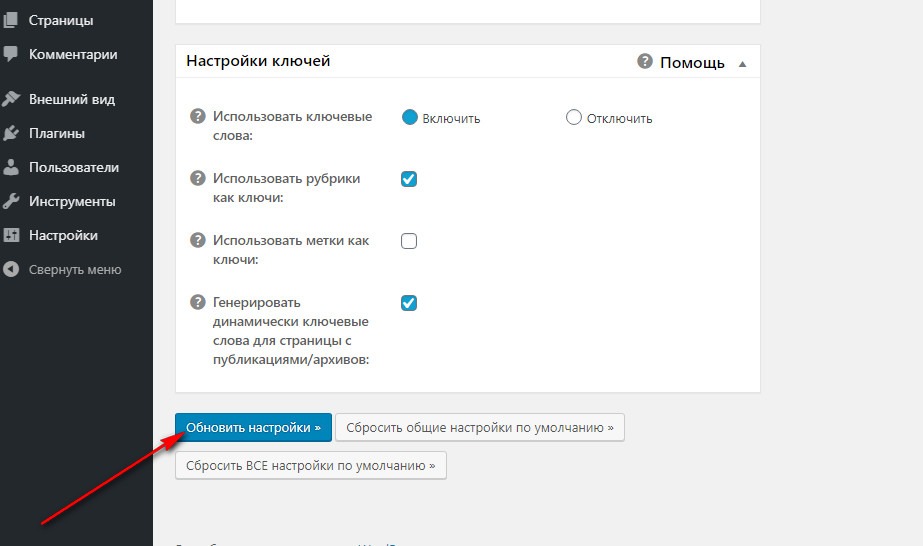

После опускаемся к пункту «Настройки ключей» и отмечаем птичками нужные пункты: «Использовать рубрики как ключи:» и «Генерировать динамически ключевые слова для страницы с публикациями/архивов:». А так же включаем «Использование ключевых слов».

После внесенных изменений жмем на » Обновить настройки». Наш All In One SEO Pack настроен для правильного SEO продвижения.

Сегодня мы с вами сделали очень важные настройки, поздравляю вас! Это был урок № 5.

На следующем уроке будем наполнять наш сайт контентом. Учиться правильно верстать тексты и вставлять виджеты, для того, чтобы статьи имели привлекательный вид.

Галина, благодарю вас за подробные инструкции, все понятно изложено и легко повторяется. Вы очень помогли мне в настройках сайта, все делала по вашим статьям и подсказкам.

Желаю вам удачи в развитии блога и радости на этом пути!

Инна, спасибо за отзыв. Вам так же успехов в блоговедении.

Галина, с этим вопросом справилась , так как все расписано понятно.

Елена, отлично! Рада, что описание как создать robots.txt Вам было полезным.